Ordnung und Wissen in die Datenflut bringen

Eine Forschungsgruppe von der Fachhochschule St. Pölten hat im Rahmen eines vom Wissenschaftsfonds FWF finanzierten Projekts eine vielseitig einsetzbare Umgebung zur Datenvisualisierung entwickelt, in der auf einfache Weise Expertenwissen integriert werden kann.

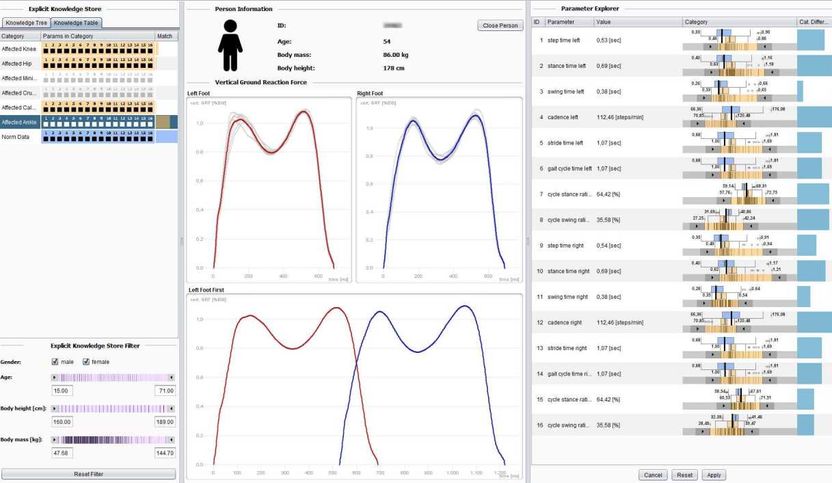

Ein Softwaretool zur Ganganalyse in der Physiotherapie, das im Rahmen des Projekts entwickelt wurde. Um nützliches Wissen aus riesigen Datenmengen zu generieren, arbeitet die Forschung an interaktiven Visualisierungsmethoden, bei denen künstliche Intelligenz und menschliches Fachwissen optimal verknüpft werden.

KAVAGait/Screenshot

Die Aufbereitung großer Datenmengen ist eines der wichtigsten Themen der Gegenwart, an dem derzeit intensiv geforscht wird. Während manche Zugänge die Datenflut mit Methoden der künstlichen Intelligenz zu bändigen versuchen, sind andere darauf aus, sie für Menschen besser aufzubereiten. Eine Forschungsgruppe um den Computerwissenschafter Wolfgang Aigner beschäftigt sich mit der Verbindung beider Zugänge und hat nun neue Methoden entwickelt, um zeitabhängige Daten verständlich darzustellen und dabei zusätzliches Wissen einfach zu integrieren.

Die Stärken von Mensch und Computer kombinieren

„Wir befinden uns hier im Bereich Visual Analytics, wo es darum geht, diese immer größeren und komplexer werdenden Datenmengen handhabbar zu machen“, sagt Wolfgang Aigner. Er spricht von einer problematischen „Informationsüberflutung“, die oft kontraproduktiv sei: „Das Ziel ist ja nicht, mehr Daten zu haben, sondern etwas herauszufinden.“ Automatisierte Informationsverarbeitung werde immer wichtiger, doch Aigner betont, wie wichtig der Mensch nach wie vor ist, wenn es darum geht, Daten zu interpretieren. „Wir Menschen sind extrem gut darin, mit visuellen Sinneseindrücken umzugehen, Fehler zu korrigieren oder unvollständige Daten zu ergänzen“, erklärt der Forscher. „Computer hingegen können sehr große Datenmengen verarbeiten, in immer gleicher Qualität. Computeralgorithmen und menschliche Informationsverarbeitung sind so in vielen Bereichen komplementär.“ Die Idee von Visual Analytics sei, beides zu kombinieren: „Wir nutzen das, was der Mensch gut kann und kombinieren es mit dem, was der Computer gut kann.“

Expertenwissen integrieren

In einem vom Wissenschaftsfonds FWF finanzierten Projekt beschäftigte sich Aigner speziell mit der Aufbereitung von zeitlich geordneten Daten, etwa medizinischer Messdaten. „Die Grundhypothese des Projekts war, dass es möglich sein sollte, zumindest einen Teil von solchem Hintergrundwissen auch in das Computersystem einzubauen und dort zu modellieren, um es auch für den Menschen wieder nutzbar zu machen“, sagt der Forscher. „Dieser Bereich wurde davor nur sehr wenig beforscht.“ Aigner und sein Team erarbeiteten also ein theoretisches Fundament. „Dabei konzentrierten wir uns auf drei Dinge“, erklärt Aigner: „Descriptive Power, also beschreibende Mächtigkeit: Kann das Modell möglichst viele schon bestehende Systeme beschreiben? Kann ich sie damit systematisch vergleichen? Dann gibt es Evaluative Power, quasi evaluierende Mächtigkeit eines Frameworks: Kann ich damit eine Aussage über die Qualität des Ergebnisses treffen? Dafür gibt es eine mathematische Beschreibung des Modells, wo man Dinge quantitativ vergleichen kann. Schließlich betrachtete man die Generative Power: Inwiefern unterstützt mich das Modell beim Bau neuer Systeme? Ist es ein Blueprint für etwas anderes? Unser Modell schafft es, alle diese drei Bereiche abzudecken.“

Prototypen

Im Rahmen des Projekts wurden zwei Fallstudien durchgeführt. „Wir haben die neuen Konzepte in zwei Beispielsituationen angewandt, einmal in der IT-Sicherheitsforschung, konkret in der Malware-Analyse, wo es um die Suche nach Schadsoftware geht, und einmal in der Physiotherapie, konkret in der Ganganalyse“, erklärt Aigner. Dazu wurden Prototypen von Computerprogrammen entwickelt. Aigner erklärt das System am Beispiel der Ganganalyse: „Der Patient, die Patientin geht über eine Druckmessplatte. Details im Abrollverhalten der Füße werden gemessen und aus den gewonnenen Daten lassen sich Rückschlüsse ziehen, etwa über Knie- oder Hüftprobleme.“ Nach der Aufzeichnung eines ganzen Schrittzyklus werden verschiedene Parameter abgeleitet, auf Basis von Expertenwissen unter Nutzung statistischer Methoden. Dieses Expertenwissen soll im Zuge der Anwendung einfach hinzugefügt werden können.

„Als Physiotherapeut weiß ich etwa, dass eine Person mit einer bestimmten Kombination an Parameterwerten ein Problem mit dem Meniskus hat. In unserem System kann ich die gesamte Messreihe mit der Maus markieren und sie mit Drag and Drop in einen Bereich auf dem Bildschirm ziehen, den ich für Meniskusprobleme angelegt habe. Da sind die Messdaten der Personen enthalten, die das Problem haben, und damit definiere ich dieses Wissen.“ Jeder neue Datensatz wird automatisch mit den abgelegten verglichen und wenn eine ähnliche Charakteristik vorliegt, weist das Programm darauf hin. Der Computer analysiert also die Daten, allerdings nur bis zu einem gewissen Punkt, wie Aigner erklärt: „Wichtig ist, dass wir nicht darauf abzielen, die Diagnose komplett zu automatisieren, sondern nur eine Unterstützung zu geben.“ Die Diagnose bleibe in der Hand der Fachleute.

Einfache Anwendbarkeit zentral

Ein besonderer Fokus liegt bei Aigners Arbeit darauf, dass die Tools einfach zu bedienen sind. „Jede Zugangshürde ist ein Problem bei wissensunterstützten Systemen in Medizin, Informatik und anderen Bereichen“, betont der Forscher. Dort sei es oft notwendig, dass jemand Programmcode schreibt oder formale Modellierungsmethoden einsetzt, wenn Zusatzwissen integriert werden soll. „Der Knackpunkt ist, dass das außerhalb der eigentlichen Arbeit mit den Tools passieren muss.“ Es dauere daher oft sehr lange oder geschehe gar nicht. „Unsere Idee in dem Projekt war, dass ich als User möglichst einfach während der Arbeit selbst dieses Wissen integrieren kann – über das User-Interface mit der Maus, mittels Drag and Drop.“

Einer der beiden Prototypen befindet sich nach wie vor im Praxiseinsatz. „Im Bereich der Malware-Analyse gab es schon während der Laufzeit des FWF-Projekts ein Spinoff-Projekt, wo mit einem Unternehmenspartner der Prototyp adaptiert wurde. Das Programm wird dort intern eingesetzt.“ In Folgeprojekten will man nun einerseits die entwickelten Konzepte weiter in die Anwendung bringen und andererseits zu der visuellen Aufbereitung auch eine „Sonifikation“ hinzufügen, also mit Klängen arbeiten.

Originalveröffentlichung

Wagner, M., Slijepcevic, D., Horsak, B., Rind, A., Zeppelzauer, M., & Aigner, W.; "KAVAGait: Knowledge-Assisted Visual Analytics for Clinical Gait Analysis"; IEEE Transactions on Visualization and Computer Graphics; 2018

Wagner, M., Rind, A., Thür, N., & Aigner, W.; "A knowledge-assisted visual malware analysis system: design, validation, and reflection of KAMAS"; Computers & Security; 2017